Je vous ai envoyé un MP.

A la maison, deux antiquités parfaitement fonctionnelles.

Le plus vieux est un Apple IIE et l’autre un PC Pentium 1 avec DOS 6.22 et Win 3.11 WG.

L’Apple me sert pour quelques jeux et son traitement de texte et le PC pour la « saga » complète de Flight Simulator 4.0b

Pour ce dernier, il me faudrait une carte graphique Tseng Labs ET4000 W32P PCI car c’est cette seule carte qui autorise l’affichage de FS4 en SVGA 800X600. Pour le moment j’ai une ATI mais Microsoft n’a pas développé de driver 800X600 pour cette carte qui pourtant serait supérieure à l’ET4000.

Bonjour,

J’ai une « vieillerie » pas banale à la maison : un « pentium PRO 175 MHz ». ca servait à faire des serveurs Internet je crois. SCSI directement sur la carte mère, pas banal non plus…

Très intéressant le SCSI sur la carte mère car cela permet des transferts de fichiers. Mon Pentium Pro 200 MHz n’a hélas rien de tout ça : pas d’USB, pas de graveur CD mais un lecteur simple, pas d’internet. Pour les échanges de fichiers, je suis obligé de sortir les disques durs IDE et avec un adaptateur IDE >> USB de les connecter à mon MacBook…

Oui, il me semble en effet que pour les transferts de fichiers le contrôleur SCSI intègre sa propre « intelligence » et ne fait pas appel au µprocesseur ?

Initialement, les interfaces étaient très primitifs et ils se limitaient souvent à guère plus qu’un accès aux bus. L’informatique de maison n’était qu’un peu en retard sur ce qui se faisait sur les grosses machines. SCSI en est un bon exemple. PATA et SATA en sont d’autres. De nos jours, ces contrôleurs sont très complexes et ils s’occupent eux-même des corrections en liaison avec leur périphériques, par exemple. Toutefois, il faut noter, qu’ils ne s’occupent pas de la structure des fichiers. NTFS, FAT, ext4, XFS et autres, ce n’est pas leur tasse de thé.

Heu, oui, bon. Sur les « grosses machines » (style IBM) des années 1970, les interfaces étaient déjà très évolués. Par contre, il fallait la centrale électrique pour alimenter le tout.

Et il fallait bien qu’ils soient évolués lorsque, comme à la direction des études et recherche à EDF, il fallait gérer plus de 400 disques durs (chacun occupant la taille d’une machine à laver), des dizaines de lecteurs de bande, etc.

Par contre, il est vrai que les chipset actuels sont d’une grande complexité. Certains disent qu’ils sont plus complexes que le processeur lui-même.

« Primitifs »

Pourquoi tu dis cela?

Les interfaces faisaient le job et personne ne leur à demandé de faire plus.

Il aurait fallu que les interfaces fassent le café?

Les interfaces disques contrôlaient les échanges avec les disques.

Les contrôleurs locaux contrôlaient les périphériques locaux. (écrans, imprimantes)

Les contrôleurs de communications géraient les échanges avec les modems en gérant les protocoles de communication.

La préhistoire, il faut bien la connaitre, sans la mépriser, car il reste encore aujourd’hui des trucs qui étaient déjà là il y a 50 ans.

Tout a évolué ensemble: les OS, le hard, les systèmes de transmission avec des échanges de plus en plus rapides, les terminaux qui ont été dotés de plus en plus de puissance de calcul.

Pour stocker un programme de quelques kilooctets une simple cassette audio avec une trés faible densité était bien suffisante.

Une liaison fiber channel à 32 Gbit/s n’aurait servi strictement à rien.

Des ressources hardware couteuses optimisées avec des programmes trés économes et performants.

Aujourd’hui nous avons des machines extraordinairement performantes et un gaspillage de cette performance car le soft coute trés cher à développer et vu le prix des machine ce n’est pas économique de l’optimiser.

On ne leur demande pas de faire le café, ni le thé de 17 h. Mais un contrôleur moderne tient quand-même des statistiques du disque qui lui est confié et cela lui permet de mieux réagir en cas d’erreurs, qu’il est capable de corriger lui même, en compagnie du disque, sans avoir à recourir au CPU, comme ce fut le cas autrefois. Par ailleurs, les spécificités du disque n’ont à être être connues que du contrôleur lui-même, sans que le CPU s’en charge. Des méthodes de corrections très spécifiques peuvent alors être employées avec bien plus de facilité qu’autrefois. Ces méthodes peuvent devenir très complexes. Finalement, tout cela conduit à plus de sécurité et d’un emploi plus facile, tout en réduisant le prix. Mais il est vrai, comme déjà constaté, que la complexité d’un contrôleur peut devenir très grande. C’est bien autre chose qu’un simple accessoire très primitif.

Je n’ai rien compris à ton propos.

Que faudrait-il comprendre?

La préhistoire pour moi, c’est en 1980, des unités disques grosses comme des lave-linges avec des gamelles amovible 5Mo (IBM, AMPEX)

La charge du contrôleur disque pour une unité de faible capacité ne demandait par un processeur dédié

avec un débit de moins d’un megabits/seconde ce qui semble ridicule aujourd’hui, mais parfaitement cohérent avec la puissance de calcul des processeurs de l’époque.

L’on parle de quoi?

De quel type de contrôleur disque? à quelle époque

Ce contrôleur disque, qui contrôle un disque de quel type avec quelle interface?

Si l’on parle d’interface disque pour les PC les premieres cartes d’interface étaient déjà bien évoluées.

L’evolution s’est faite de manière continue et c’est pas fini.

L’on a des aujourd’hui des unités de disque avec des capacité de stockages phénoménales, il faut des temps d’accès et des debits de plusieurs dizaines de gigabits/seconde. l’on a des baies de stockages avec leurs processeurs dédiées, de la redondance, c’est simplement en correspondance avec le besoin de performance des processeurs et des vitesses considérables sur les réseaux.

Plutôt années 1970. Pour les disque 5Mo que j’ai connu (années 1970) sur miniordinateur (Mitra15, Voir photo reconstituée sur mon site), c’était gros mais la taille était de l’ordre de peut-être un quart de machine à laver (nouvelle unité de mesure) pour les SAGEM (5Mo amovible + 5Mo fixe).

Dans les mêmes années, j’ai connu les 3330 et (surtout) les 3350 d’IBM qui datent des années 1970 et qui avaient une capacité entre 200 et 300Mo. C’est ceux-là qui prenaient la place d’une (grosse) machine à laver.

En 1982 ou 1983, on avait des PC-XT (IBM) qui avaient des disques durs au format 5"1/4 avec une capacité de 10Mo.

le mitra 15 de la CII etait une copie plus ou moins reussie du PDP8

le but principal etait de pouvoir fournir aux industriels et a l’armée un équipement informatique non dépendant du bon gré des USA lorsque l’on exportait vers des pays étrangers considérés comme chasse gardée par les US ou sous embargo US

pour les radars cyrano

les machines de fabrication utilisaient des PDP8

les bancs de test utilisaient des Mitra 15

Je ne sais plus les capacités exactes des disques, c’était y’a bien longtemps, et j’ai fait tout autre chose ensuite.

à l’époque je faisais de la maintenance et du support, chez les clients de périphériques compatibles pour les gros systèmes IBM, Amdahl, Fujitsu et Hitachi. Disques, dérouleurs de bande, contrôleurs pour les terminaux, et autres bricoles.

Plusieurs jours de formation sur chaque version de produit, probablement plusieurs milliers d’heures de formation en tout.

L’on démontait les disques en atelier, y’avait pas de salle blanche comme aujourd’hui, une mécanique ressemblant à de l’horlogerie, changer les plateaux et les têtes suite à un crash, travailler propre, serrage au couple de toutes les vis, enlever la moindre poussière, puis lancer la purge pendant plusieurs heures pour capturer les poussières restantes avant d’avancer les têtes et reformater l’unité disque. C’est un monde et un savoir qui a complètement disparu.

Difficile d’imaginer ce qu’étaient les premiers disques durs pour ceux qui ne voient pour la préhistoire que les disques durs 3"1/2 de PC et les disquettes 3"1/2 sans jamais avoir vu de disquette 5"1/4 ou 8".

L’évolution va à une vitesse fantastique.

Bonjour,

La préhistoire au travail : le Multi 8 et le Multi 20, d Intertechnique, matériel Français à rubzn perforé…

Citons également les pc de chez Goupil, français également…

Bonjour,

Un collègue en avait un (ZX81), on faisait des stats dessus, imprimante sur des rouleaux genre ticket de caisse.

J’avais aussi une calculatrice HP 1011 (de mémoire, je ne l’ai jamais retrouvé), 124 pas de mémoire, mais en polonais inversé. Ce langage machine permettait de gagner en vitesse, nombre a, nombre b, opération, au lieu de nombre a, opération, nombre b, égal. Sur des centaines de calculs on apprécie, d’ailleurs j’ai réussi un concours comme ça où il fallait faire des tableaux de stats.

Amitiés Christian

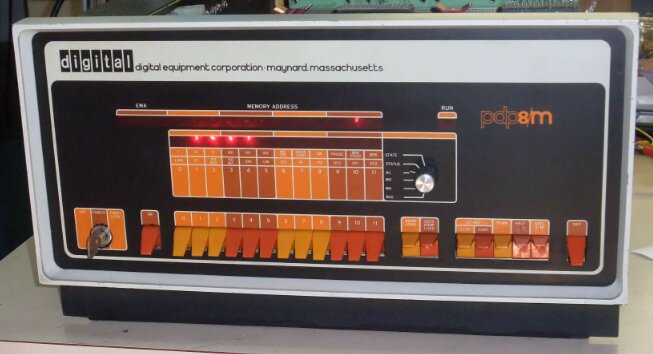

Le PDP8/M sur la photo est un modèle récent ![]() Il a des LED plutôt que des loupiotes. Le Mitra15 n’avait que des loupiotes.

Il a des LED plutôt que des loupiotes. Le Mitra15 n’avait que des loupiotes.

Le Mitra 15 était une bonne machine. Il a effectivement pas mal été utilisé par l’armée (dont en conduite de tir sur des navires).

Les Mitra qui ont suivi (125 jusqu’à 625) étaient par contre complètement loupés (de mon point de vue).

Et on ne parle plus des disques à têtes fixes. Dans le centre de calcul d’EDF (le plus gros en Europe à l’époque), il y avait plusieurs niveaux de mémoire:

Les mémoires centrales des IBM (il y en avait un paquet)

Les antémémoires :

A partir de 1981, une énorme baie (plusieurs mètres de long, peut-être deux mètres de haut) remplie de RAM dynamique.

Les disques à tête fixe (il n’y en avait pas beaucoup mais je n’ai plus le nombre en tête)

Les mémoires de masse « classiques »

Les disques fixe (400 en 1980)

Les disques amovibles (pas beaucoup, quelques dizaines)

Les lecteurs de bandes (peut-être une dizaine).

Pas loin d’un demi terrain de foot (c’est l’impression que ça me donnait) rien que pour tout ce qui avait trait aux IBM (plus deux vieux Control Data).

Après sont arrivés les Cray en complément

Sinon, il y avait des centaines d’autres ordinateurs (H66-60, Mini6/DPS6, Mitra 125 à 625, DPS7…), certains à Clamart, d’autres répartis dans d’autres centres en France)

Tout cela était utilisé à des fins scientifiques et techniques (il y avait aussi un centre de calcul de gestion ailleurs).

Je n’ai pas fait le calcul mais en puissance brute, un ou quelques smartphones doivent faire beaucoup mieux aujourd’hui.

Ceci dit, IBM continue de produire des mainframe qui sont largement utilisés dans le secteur bancaire. Et ce sont de beaux monstres pour ce que j’ai pu voir. Et ils tournent toujours sous MVS !

Le dernier gros IBM que j’ai vu mis en route c’était en 2010 (dans le monde bancaire).

Bonjour,

@Chour_Pascal

J’ai un Mitra 15 récupéré a l’usine en 86 avec quelques classeurs de docs hard, mais pas tous!

Son petit frère a été maintenu en parfait état de marche jusqu’en 2020 dans le cadre du programme M45, j’ai appris qu’au démantèlement du programme , il a été minutieusement réduit en petits morceaux. Quel sacrilège, il aurait eu sa place dans un musée, mais je n’étais plus la pour le sauver!

Sur le meme programme il y avait aussi encore en état de marche deux ULP SAGEM (16 bits a base de micro en tranches TTL 1973-74), j’en ai aussi un civil qui était monté sur les machines outils mais je n’ai pas pensé récupérer la doc à l’époque!

Dans les années 90, sur marché d’Etat, j’ai écrit un cross assembleur sur PC et un émulateur de lecteur de bandes pour l’ULP. Avant les programmes était faits sur un système PETAL SAGEM qui occupait une pièce entière et il fallait une bonne journée pour générer un programme, une minute pour le meme travail sur PC!

Souvenirs, souvenirs…

Bon, ULP, je ne me souviens pas. Par contre, je vois tout à fait l’intérêt d’écrire un cross assembleur sur PC! Il ne reste désormais plus qu’à écrire un émulateur de Mitra15 mais je crains que ce soit une autre histoire vu la gestion des interruptions de l’engin.

Et pour ma part, je n’ai conservé aucun programme que j’ai écrit (entre-autres, j’avais fait un désasssembleur (pour désassembler le moniteur temps réel) et un gestionnaire de fichier pour utiliser le disque DRI).

J’ai numérisé tous les documents que j’avais conservé sur cet ordinateur (dispo sur mon site) mais je n’ai rien (ou pas grand chose) sur le hard. Si jamais…

Doctsf (Modèles & Marques)

Doctsf (Modèles & Marques) Annonces

Annonces